A/B-Tests funktionieren garantiert!

Wir empfehlen ja regelmäßig, das Optimieren von Mailings mit A/B-Tests zur Gewohnheit zu machen. Denn das kostet nur wenige Minuten Aufwand, ist einfach umsetzbar und ohne Kosten verbunden.

Doch es gibt noch einen weiteren gewichtigen Grund, weshalb A/B-Tests empfehlenswert sind: Sie verbessern die Kennzahlen – und zwar garantiert!

Dazu ein einfaches Rechenbeispiel, das vielleicht so manches Auge öffnen wird.

Ein kleines Gedankenexperiment

Angenommen, Sie möchten ein Mailing an 20.000 Empfänger verschicken. Dafür würden Ihnen 3 verschiedene Betreffzeilen einfallen, die Öffnungsraten wie folgt erzielen würden (was Sie vorher natürlich nicht wissen können!):

Betreff A: 36%

Betreff B: 32%

Betreff C: 28%

Bei diesem Beispiel gehen wir davon aus, dass alle 3 Varianten die gleiche Eintritts-Wahrscheinlichkeit haben, d.h. Sie wissen vorab tatsächlich nicht, welche der drei Betreffzeilen besonders gut oder schlecht abschneiden wird.

Ergebnis OHNE A/B-Test

Wenn Sie keinen A/B-Test für die 3 Betreffzeilen durchführen, müssen Sie logischerweise raten und eine davon wird verschickt.

Betreff A: 36% mit Wahrscheinlichkeit = 33% --> 12%

Betreff B: 32% mit Wahrscheinlichkeit = 33% --> 10,7%

Betreff C: 28% mit Wahrscheinlichkeit = 33% --> 9,3%

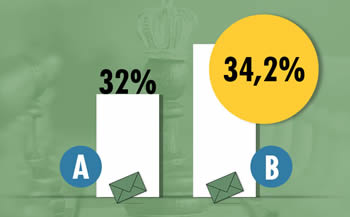

Fazit: Ohne A/B-Test erreichen Sie einen durchschnittliche Öffnungsrate von 32%.

Ergebnis MIT A/B-Test

Für dieses Mailing würde man einen A/B-Test mit Gewinner-Versand durchführen – und der macht den Unterschied.

Das funktioniert so:

- Zuerst werden die 3 Betreffzeilen an je 3.000 Empfänger verschickt (und die restlichen 11.000 werden vorerst zurückgehalten) – das machen gute Newsletter-Systeme wie Dialog-Mail automatisch.

- Dann werden für eine kurze Zeit (normalerweise wenige Stunden) die Öffnungsraten der drei Varianten in Echtzeit gemessen.

- Sobald eine davon statistisch signifikant besser abschneidet als die anderen beiden (oder spätestens nach einer einstellbaren Wartezeit), wird automatisch die Gewinner-Variante an die restlichen 11.000 Empfänger verschickt. Auch das machen die modernen Systeme alles automatisch.

Konkret bedeutet das für unser kleines Beispiel:

3.000 Empfänger bekommen die Variante A -> 36% ÖR

3.000 Empfänger bekommen die Variante B -> 32% ÖR

3.000 Empfänger bekommen die Variante C -> 28% ÖR

11.000 Empfänger bekommen die Variante A -> 36% ÖR (Gewinner-Versand)

Das Ergebnis: In Summe erzielen Sie für die 20.000 Empfänger eine Öffnungsrate von 34,2%.

Fazit: Eine deutlich bessere Öffnungsrate

Durch die Durchführung des A/B-Tests (mit Gewinner-Versand) erreichen Sie also 440 mehr Öffnungen. Das sind knapp 7% mehr als bei der Variante ohne Test. Immerhin, oder?

Angesichts der Tatsache, dass die Umsetzung so eines A/B-Tests im Normallfall nur 2 oder 3 Minuten mehr Zeit in Anspruch nimmt, gibt es doch wirklich keine Ausrede mehr, um nicht zu testen. Oder?

Übrigens, auch wenn die Unterschiede zwischen den 3 Varianten geringer wären, würde ein A/B-Test zum besseren Ergebnis führen.

Bonus: Brauchen Sie frische Ideen für Test-Elemente?

Wenn Sie etwas ratlos sein sollten, welche Elemente eines Mailings Sie testen können: Wir haben in einem ausführlichen Blog-Artikel nicht weniger als 150 Ideen für Newsletter A/B-Test-Elemente gesammelt.

Von einem Menschen geschrieben!

Alle unsere Blog-Artikel werden durch einen echten Menschen (Michael Kornfeld) geschrieben. Es kommt keine KI zum Einsatz. Wir finden das wichtig, denn KI-generierten Schrott gibt es genug.

Möchten Sie noch mehr Inspirationen?

In unserem Newsletter bekommen Sie rund 1x/Quartal neue Studien, Aktuelles aus dem Markt, spannende Trends, neue Whitepaper und E-Mail-Marketing Best Practices. Aus der Praxis, für die Praxis. Kostenlos in Ihrer Inbox.

Am besten gleich anmelden!